Trong bối cảnh công nghệ AI đang phát triển vượt bậc, các chatbot AI dựa trên đám mây như ChatGPT hay Gemini đã trở nên quen thuộc, mang lại sự tiện lợi đáng kinh ngạc. Tuy nhiên, đi kèm với đó là những đánh đổi về quyền riêng tư dữ liệu và khả năng truy cập. Một giải pháp thay thế đang ngày càng được quan tâm là chạy các mô hình ngôn ngữ lớn (LLM) cục bộ – nền tảng công nghệ đằng sau các chatbot AI – ngay trên thiết bị của bạn. Điều này không chỉ giúp bạn kiểm soát hoàn toàn dữ liệu mà còn cho phép truy cập ngoại tuyến, đảm bảo quyền riêng tư tối đa. Dù nghe có vẻ kỹ thuật, nhưng với những ứng dụng phù hợp, việc bắt đầu với LLM cục bộ trở nên dễ dàng hơn bao giờ hết cho bất kỳ ai. Bài viết này sẽ giới thiệu 5 ứng dụng hàng đầu giúp bạn khai thác sức mạnh của AI mà vẫn giữ dữ liệu cá nhân an toàn trên máy tính của mình.

Việc vận hành LLM cục bộ mang lại nhiều lợi ích vượt trội:

- Quyền riêng tư dữ liệu tăng cường: Mọi tương tác và dữ liệu của bạn đều nằm trên thiết bị cá nhân, không bị gửi lên máy chủ đám mây của bên thứ ba.

- Truy cập ngoại tuyến: Bạn có thể sử dụng chatbot AI mà không cần kết nối internet, lý tưởng cho những lúc di chuyển hoặc ở những nơi sóng yếu.

- Kiểm soát hoàn toàn: Tùy chỉnh mô hình, tích hợp vào các quy trình làm việc riêng của bạn một cách linh hoạt.

Dưới đây là danh sách các ứng dụng giúp bạn biến điều này thành hiện thực.

5. Ollama: Sự Đơn Giản Dành Cho Mọi Người

Ollama là một ứng dụng thân thiện với người dùng, được thiết kế để giúp các cá nhân chạy các mô hình ngôn ngữ lớn (LLM) cục bộ một cách hiệu quả mà không đòi hỏi chuyên môn kỹ thuật sâu. Điểm nổi bật của Ollama là khả năng vận hành các mô hình AI mạnh mẽ ngay trên phần cứng phổ thông như máy tính xách tay. Ứng dụng này được đánh giá cao nhờ sự đơn giản và tính dễ tiếp cận, không yêu cầu thiết lập phức tạp.

Ollama hỗ trợ nhiều loại mô hình khác nhau và có sẵn ứng dụng trên macOS, Windows và Linux, đảm bảo khả năng tương thích với hầu hết các nền tảng phổ biến. Quy trình cài đặt rất đơn giản, và chỉ trong chốc lát, bạn đã sẵn sàng chạy LLM trên thiết bị của mình. Để khởi chạy một mô hình, bạn chỉ cần sử dụng lệnh ollama run [mã định danh mô hình]. Ví dụ, để chạy mô hình Phi 4 của Microsoft, bạn chỉ cần nhập lệnh sau:

ollama run phi4Hoặc với Llama 4, bạn dùng lệnh:

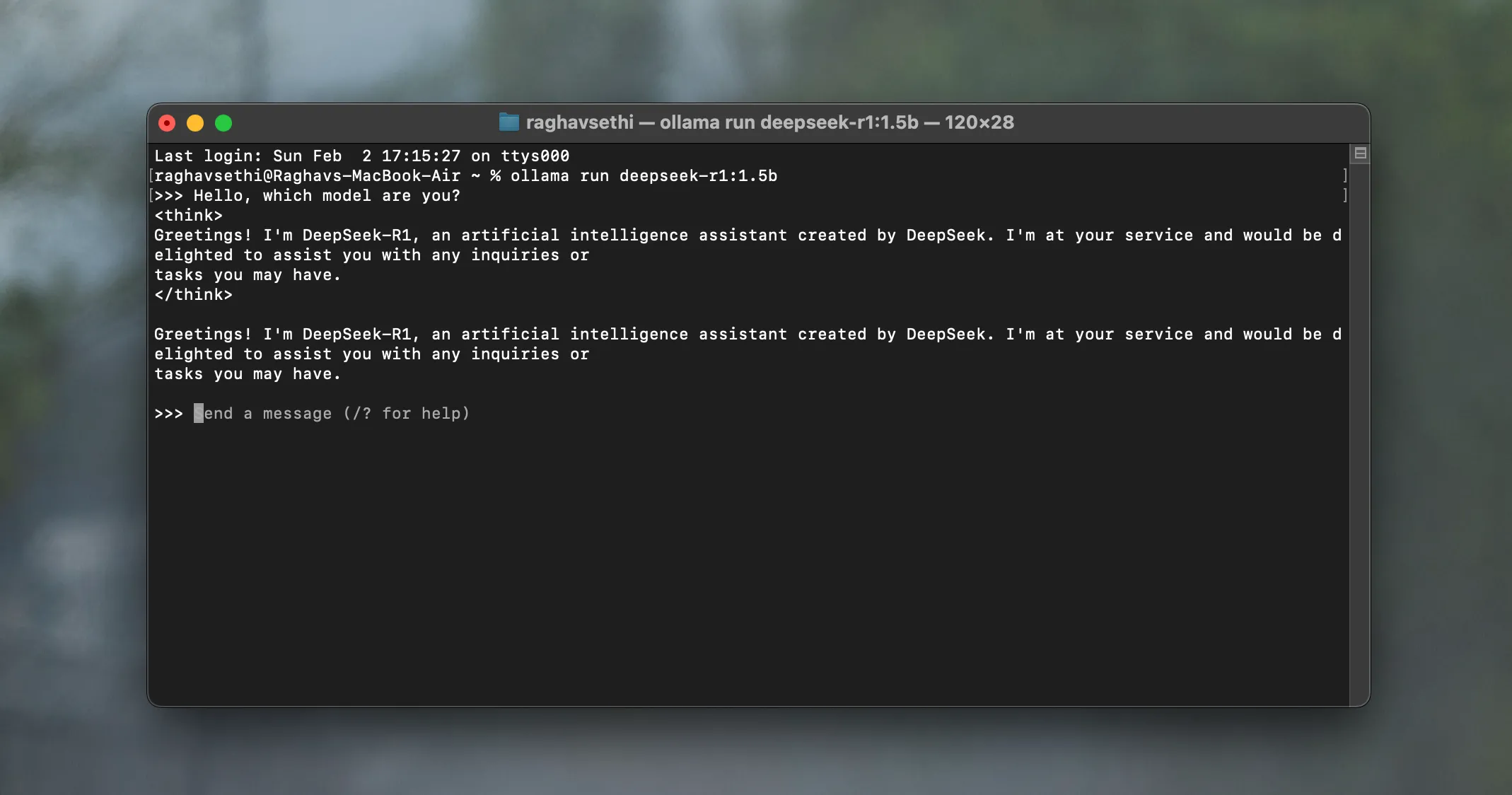

ollama run llama4Mô hình được chỉ định sẽ tự động tải xuống và bắt đầu chạy, cho phép bạn trò chuyện trực tiếp với nó từ giao diện dòng lệnh. Chẳng hạn, bạn có thể chạy DeepSeek cục bộ trên máy tính xách tay một cách dễ dàng với Ollama.

Giao diện dòng lệnh Ollama chạy mô hình DeepSeek-R1, minh họa cách vận hành LLM cục bộ dễ dàng.

Giao diện dòng lệnh Ollama chạy mô hình DeepSeek-R1, minh họa cách vận hành LLM cục bộ dễ dàng.

4. Msty: Giao Diện Trực Quan, Trải Nghiệm Cao Cấp

Tương tự như Ollama, Msty là một ứng dụng thân thiện người dùng khác, được thiết kế để đơn giản hóa việc chạy các LLM cục bộ. Có sẵn cho Windows, macOS và Linux, Msty loại bỏ những phức tạp thường gặp khi vận hành LLM cục bộ, chẳng hạn như cấu hình Docker hay giao diện dòng lệnh.

Msty cung cấp một thư viện phong phú các mô hình mà bạn có thể chạy trên thiết bị của mình, bao gồm các tùy chọn phổ biến như Llama, DeepSeek, Mistral và Gemma. Bạn cũng có thể trực tiếp tìm kiếm các mô hình trên Hugging Face – một trong những nguồn tài nguyên hàng đầu để khám phá các chatbot AI mới. Sau khi cài đặt, ứng dụng sẽ tự động tải xuống một mô hình mặc định về thiết bị của bạn.

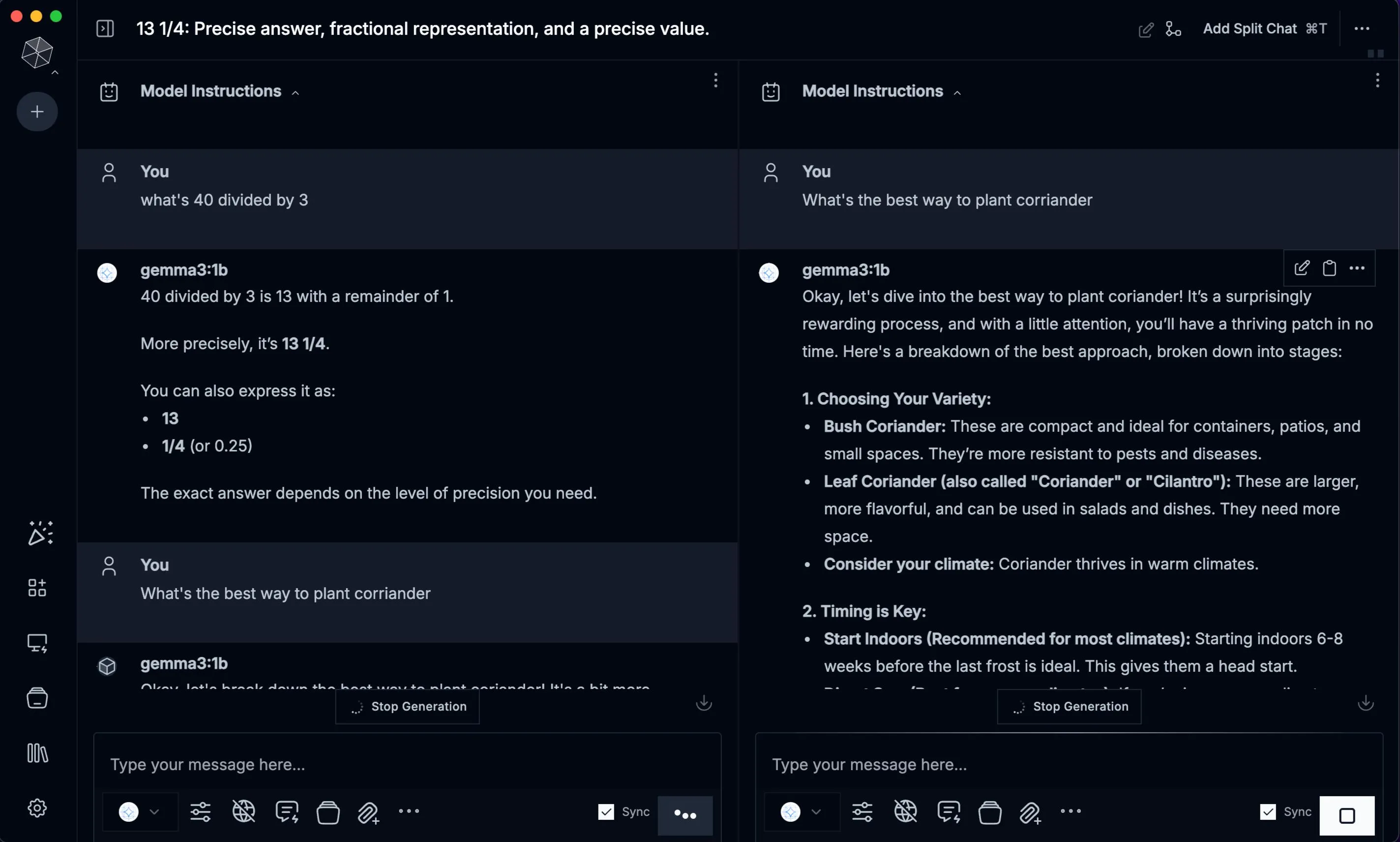

Từ đó, bạn có thể tải xuống bất kỳ mô hình nào từ thư viện theo ý muốn. Nếu bạn muốn tránh xa hoàn toàn giao diện dòng lệnh, Msty chính là ứng dụng lý tưởng dành cho bạn. Giao diện dễ sử dụng của nó mang lại trải nghiệm cao cấp và trực quan. Ứng dụng này cũng bao gồm một thư viện các gợi ý (prompts) với nhiều tùy chọn tạo sẵn, giúp bạn hướng dẫn các mô hình LLM và tinh chỉnh phản hồi. Ngoài ra, Msty còn có tính năng không gian làm việc (workspaces) để bạn sắp xếp các cuộc trò chuyện và tác vụ một cách ngăn nắp.

Giao diện ứng dụng Msty trên macOS, thể hiện khả năng chạy LLM cục bộ với trải nghiệm thân thiện.

Giao diện ứng dụng Msty trên macOS, thể hiện khả năng chạy LLM cục bộ với trải nghiệm thân thiện.

3. AnythingLLM: Linh Hoạt Và Mạnh Mẽ

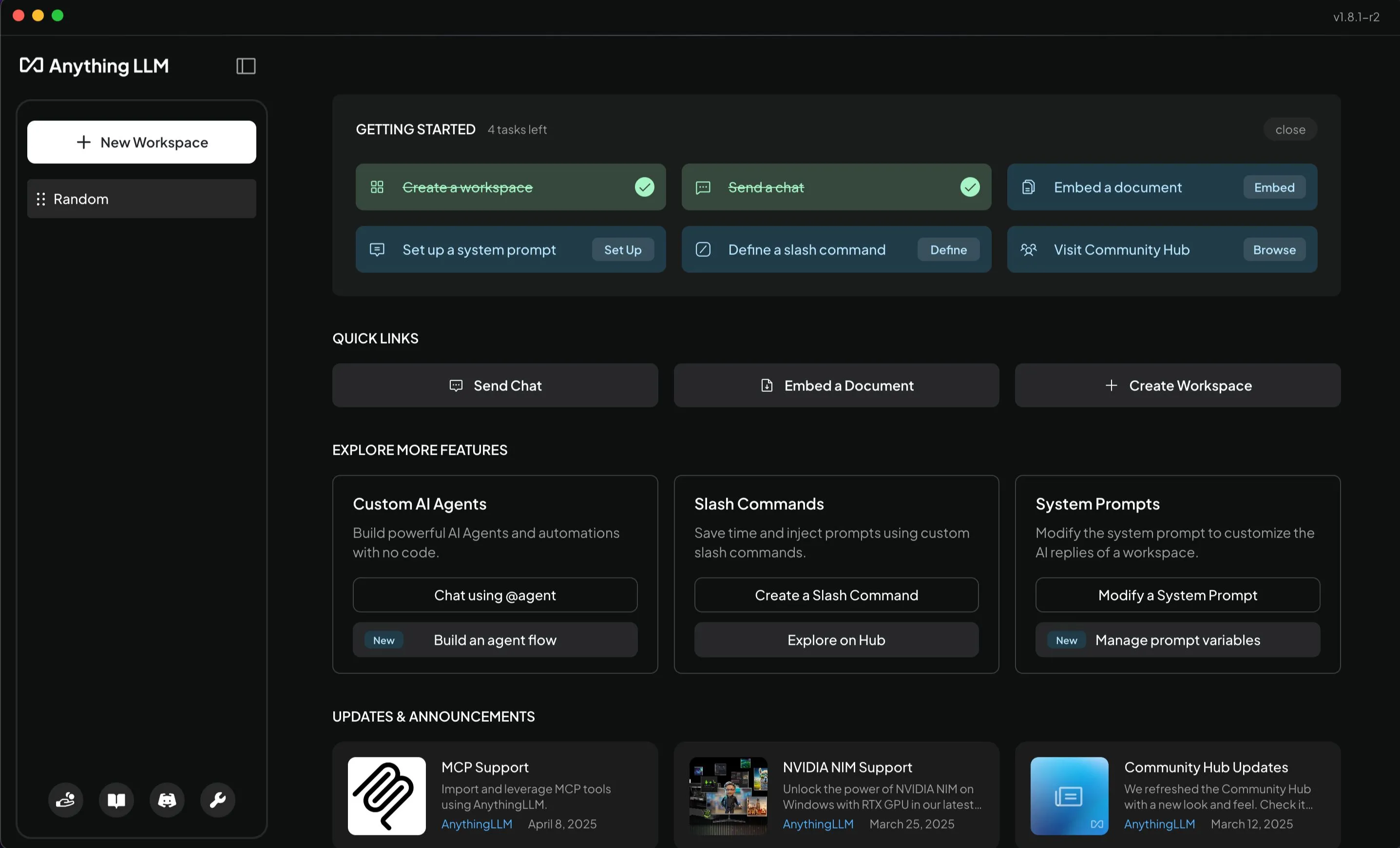

AnythingLLM là một ứng dụng desktop tiện dụng được thiết kế dành cho những người dùng muốn chạy các mô hình ngôn ngữ lớn (LLM) cục bộ mà không cần thiết lập phức tạp. Từ khâu cài đặt cho đến việc gửi gợi ý đầu tiên, quy trình diễn ra mượt mà và trực quan. Trải nghiệm sử dụng AnythingLLM mang lại cảm giác tương tự như đang sử dụng một LLM dựa trên đám mây.

Trong quá trình thiết lập, bạn có thể tải xuống các mô hình mình lựa chọn. Một số LLM ngoại tuyến tốt nhất hiện nay, bao gồm DeepSeek R1, Llama 4, Microsoft Phi 4, Phi 4 Mini và Mistral, đều có sẵn để tải về. Giống như hầu hết các ứng dụng trong danh sách này, AnythingLLM là một dự án mã nguồn mở hoàn toàn.

Ứng dụng này bao gồm trình cung cấp LLM riêng và cũng hỗ trợ nhiều nguồn bên thứ ba khác, trong đó có Ollama, LM Studio và Local AI, cho phép bạn tải xuống và chạy các mô hình từ những nguồn này. Nhờ khả năng tích hợp linh hoạt này, AnythingLLM cho phép bạn vận hành hàng trăm, thậm chí hàng nghìn mô hình LLM có sẵn trên web.

Màn hình chính của ứng dụng AnythingLLM trên macOS, cung cấp giao diện trực quan cho việc chạy LLM cục bộ.

Màn hình chính của ứng dụng AnythingLLM trên macOS, cung cấp giao diện trực quan cho việc chạy LLM cục bộ.

2. Jan.ai: Giải Pháp Nguồn Mở Thay Thế ChatGPT Offline

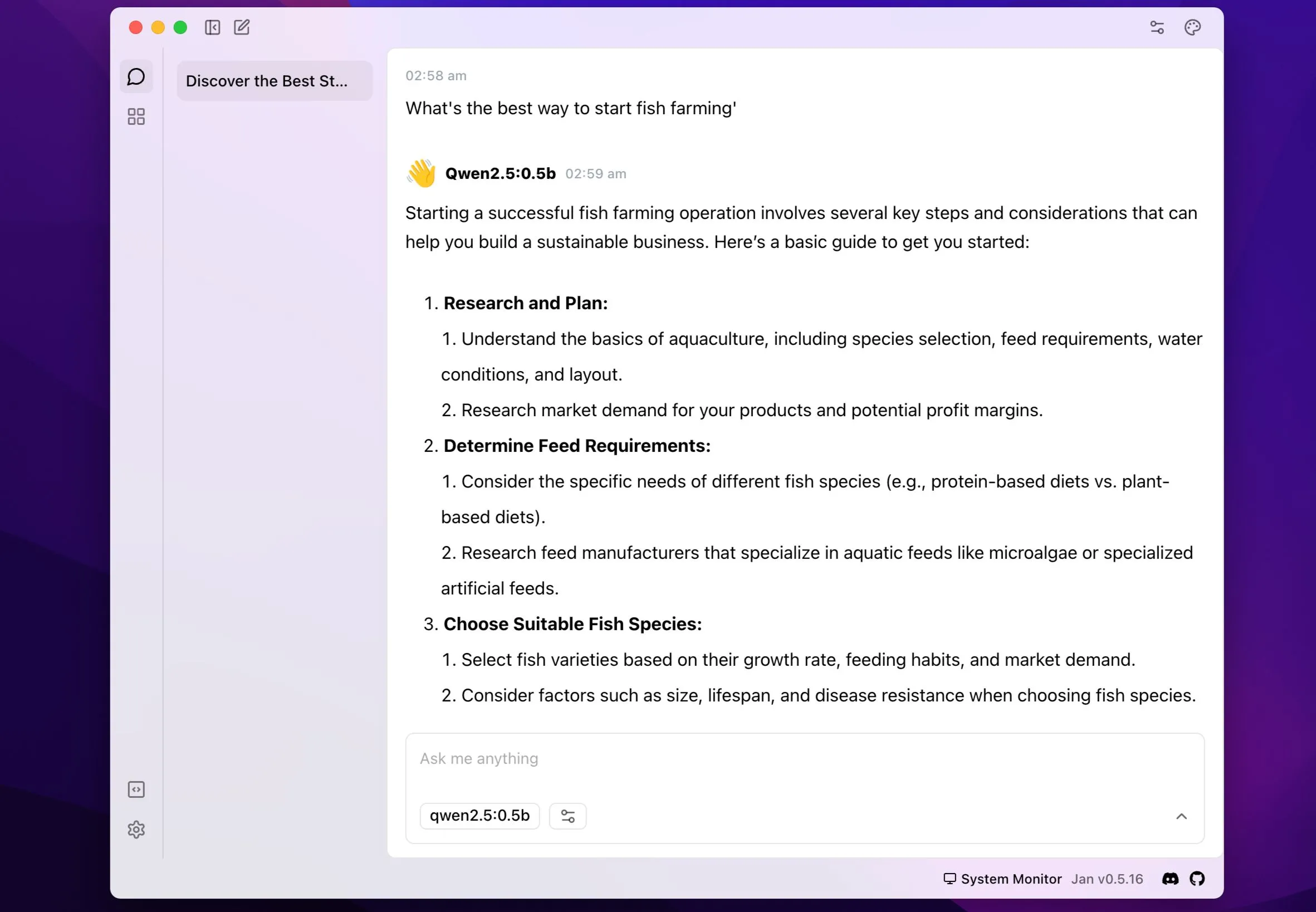

Jan tự quảng bá mình là một lựa chọn thay thế ChatGPT mã nguồn mở, có khả năng chạy ngoại tuyến. Ứng dụng này cung cấp một giao diện desktop mượt mà để vận hành các mô hình LLM khác nhau ngay trên thiết bị của bạn. Việc bắt đầu với Jan rất dễ dàng. Ngay sau khi cài đặt ứng dụng (có sẵn trên Windows, macOS và Linux), bạn sẽ được cung cấp một số mô hình LLM để tải xuống.

Mặc dù ban đầu chỉ hiển thị một vài mô hình, nhưng bạn có thể tìm kiếm hoặc nhập URL từ Hugging Face nếu không thấy mô hình mình mong muốn. Bạn cũng có thể nhập một tệp mô hình (ở định dạng GGUF) nếu bạn đã có sẵn nó trên thiết bị cục bộ. Việc này thực sự không thể dễ dàng hơn. Ứng dụng này cũng bao gồm các LLM dựa trên đám mây trong danh sách của nó, vì vậy hãy đảm bảo áp dụng bộ lọc phù hợp để loại trừ chúng nếu bạn chỉ muốn các mô hình cục bộ.

Giao diện ứng dụng Jan.ai hiển thị cuộc trò chuyện với mô hình Qwen LLM chạy cục bộ, thể hiện tính năng AI offline hiệu quả.

Giao diện ứng dụng Jan.ai hiển thị cuộc trò chuyện với mô hình Qwen LLM chạy cục bộ, thể hiện tính năng AI offline hiệu quả.

1. LM Studio: Cổng Dễ Dàng Đến Với LLM Cục Bộ

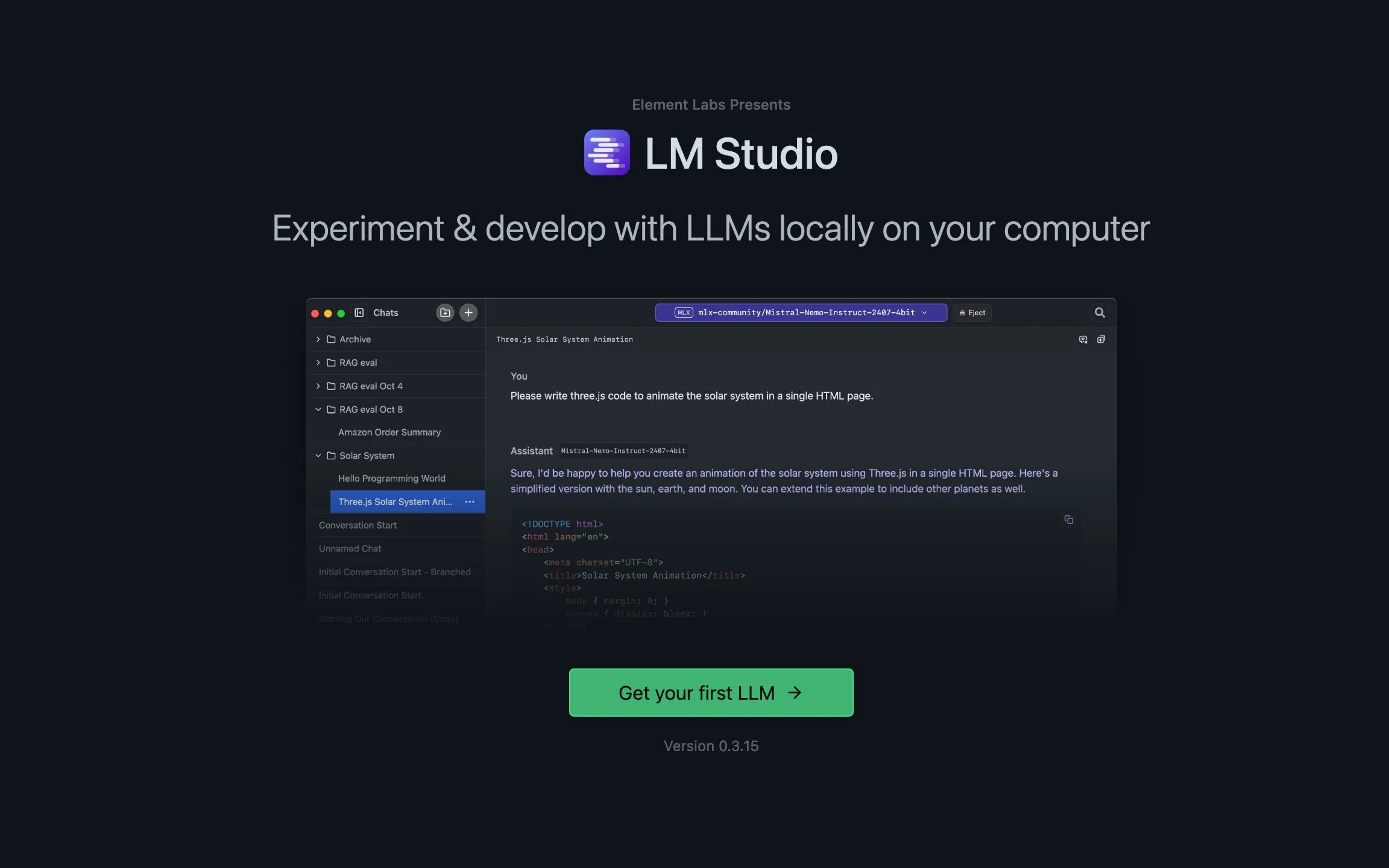

LM Studio là một ứng dụng khác cung cấp một trong những cách dễ tiếp cận nhất để chạy các mô hình ngôn ngữ lớn (LLM) cục bộ trên thiết bị của bạn. Ứng dụng desktop này (có sẵn trên macOS, Windows và Linux) cho phép bạn dễ dàng vận hành các LLM ngay trên máy tính cá nhân.

Sau khi thiết lập, bạn có thể duyệt và tải các mô hình phổ biến như Llama, Mistral, Gemma, DeepSeek, Phi và Qwen trực tiếp từ Hugging Face chỉ với vài cú nhấp chuột. Khi đã tải xong, mọi thứ đều chạy ngoại tuyến, đảm bảo các gợi ý và cuộc trò chuyện của bạn luôn được giữ riêng tư trên thiết bị. Ứng dụng tự hào có giao diện người dùng trực quan, quen thuộc, vì vậy bạn sẽ cảm thấy hoàn toàn thoải mái nếu đã từng sử dụng các LLM dựa trên đám mây như Claude.

Màn hình chào mừng của ứng dụng LM Studio, hướng dẫn người dùng bắt đầu với các mô hình LLM cục bộ.

Màn hình chào mừng của ứng dụng LM Studio, hướng dẫn người dùng bắt đầu với các mô hình LLM cục bộ.

Có nhiều cách để chạy mô hình ngôn ngữ lớn trên Linux, Windows, macOS hay bất kỳ hệ điều hành nào bạn sử dụng. Tuy nhiên, các ứng dụng được liệt kê ở đây cung cấp một số phương pháp dễ dàng và tiện lợi nhất để thực hiện điều đó. Một số ứng dụng có thể yêu cầu một chút tương tác với giao diện dòng lệnh, trong khi những ứng dụng khác, như AnythingLLM và Jan.ai, cho phép bạn thực hiện mọi thứ thông qua giao diện đồ họa người dùng (GUI). Tùy thuộc vào mức độ thoải mái với công nghệ của bạn, hãy thử nghiệm một vài ứng dụng và gắn bó với ứng dụng phù hợp nhất với nhu cầu của bạn.

Việc khai thác sức mạnh của LLM cục bộ đang mở ra một kỷ nguyên mới về quyền riêng tư và sự linh hoạt trong trải nghiệm AI cá nhân. Khám phá thêm các bài viết chuyên sâu về công nghệ AI và những xu hướng mới nhất tại diemhencongnghe.com để không bỏ lỡ những thông tin giá trị. Hãy chia sẻ trải nghiệm của bạn với các ứng dụng này dưới phần bình luận!